Gastartikel

Doping im Radsport war in den letzten Jahrzehnten weit verbreitet. Wir dürfen davon ausgehen, dass es zumindest bei der Tour kaum saubere Spitzenleistungen gegeben hat. Team Sky beruft sich nun auf verbesserte Trainingsmethoden, Akribie hinsichtlicher technischer Aspekte und beste individuelle Betreuung ihrer Sportler und will so die zum Teil herausragenden Leistungen ihrer Sportler erklären. Ist das plausibel?

Um dies zu diskutieren, sollte man sich anschauen, welches Wissen und auch welche Technik den Sportlern heute zur Verfügung steht, das vor 5-10 Jahren noch nicht zur Verfügung stand und das ganze vor den Leistungsanforderungen eines möglichen Toursiegers.

Wie sehen Toursieger aus?

Offensichtlich müssen Radsportler, die schnell Berge hochfahren wollen, sehr leicht sein. Da die Berge bei der Tour bis zu 20 km lang sind und Aufstiegszeiten von bis zu einer Stunde benötigen, wird letztlich derjenige am Ende vorne sein, dessen relative Leistungsfähigkeit in einem Zeitfenster von 20-60 Minuten am besten ist. Aus den Aufstiegszeiten und dem Gewicht des Sportlers lassen sich dann Watt/ kg ausrechnen.

Bei Sprintern ist die Rechnung noch komplexer. Hier wird die absolute Wattleistung in Bezug zur Aerodynamik des Sportlers gesetzt. Kleine Fahrer wie Cavendish, die es schaffen, ihren Kopf bei Tempo 70 auf Lenkerhöhe zu halten, brauchen im Sprint geschätzte 200-300 Watt weniger als Sportler mit einer Figur und Haltung von Greipel.

Das Talent und normales Training bringt unseren Sportler vielleicht auf eine Leistungsfähigkeit von 420 Watt in der Stunde. Der Sportler wiegt 74 kg und seine relative Stundenleistung beträgt 5,67 W/ kg. Das ist nicht schlecht und würden diesen Profi auf jeden Fall zu einem sehr wertvollen Helfer auf Flachetappen machen und er könnte in der Position 3-5 am Berg auch noch Helfer für seinen Kapitän sein. Wenn unser Sportler aber nun von diesen 74 kg 10 kg verlieren würde – ohne Leistungsfähigkeit einzubüssen – hätten wir seine Leistungsfähigkeit auf 6,54 Watt/kg erhöht und sind in den Leistungsbereichen, die z.B. von Vayer mit Doping erklärt werden.

Wir sehen also, dass wir allein durch eine strikte Diät aus einem guten Profi einen Toursieger machen können. Natürlich werden auch Muskeln am Oberkörper Opfer dieser Diät. Das ist aber gewollt, jeder Muskel, der nicht benötigt wird, muss zusätzlich mit Sauerstoff versorgt werden. Unser Radsportler würde idealer Weise ergänzend ein Übungsprogramm absolvieren, z.B. Yoga, Pilates, Coretraining, um den Aufbau und Erhalt einer schlanken Muskulatur zu unterstützen. Das sind natürlich nur Zahlenspiele, die die Rolle des Körpergewichtes veranschaulichen sollen.

Amüsant ist, dass in einigen Medien neue Wundermittel aufgeführt werden, die den Profis helfen sollen, ihr mageres Gewicht zu erreichen. Um 10 kg abzunehmen brauchen wir ein Kaloriendefizit von 70.000 kcal. Sie glauben das ist viel? Ein Profi hat kein Problem im normalen Training 3500 kcal zusätzlich zu verbrennen. Das sind 20 Trainingstage und der Athlet müsste dann noch nicht einmal auf seine täglichen 2500 kcal verzichten. Natürlich würden die Profis, um ihre Leistungsfähigkeit zu halten, diese Diät auf einen Zeitraum von vielleicht 60 Tagen ausdehnen. Kein Profi, der messen und wiegen kann, braucht ein Mittel, dass die Fettverbrennung steigert.

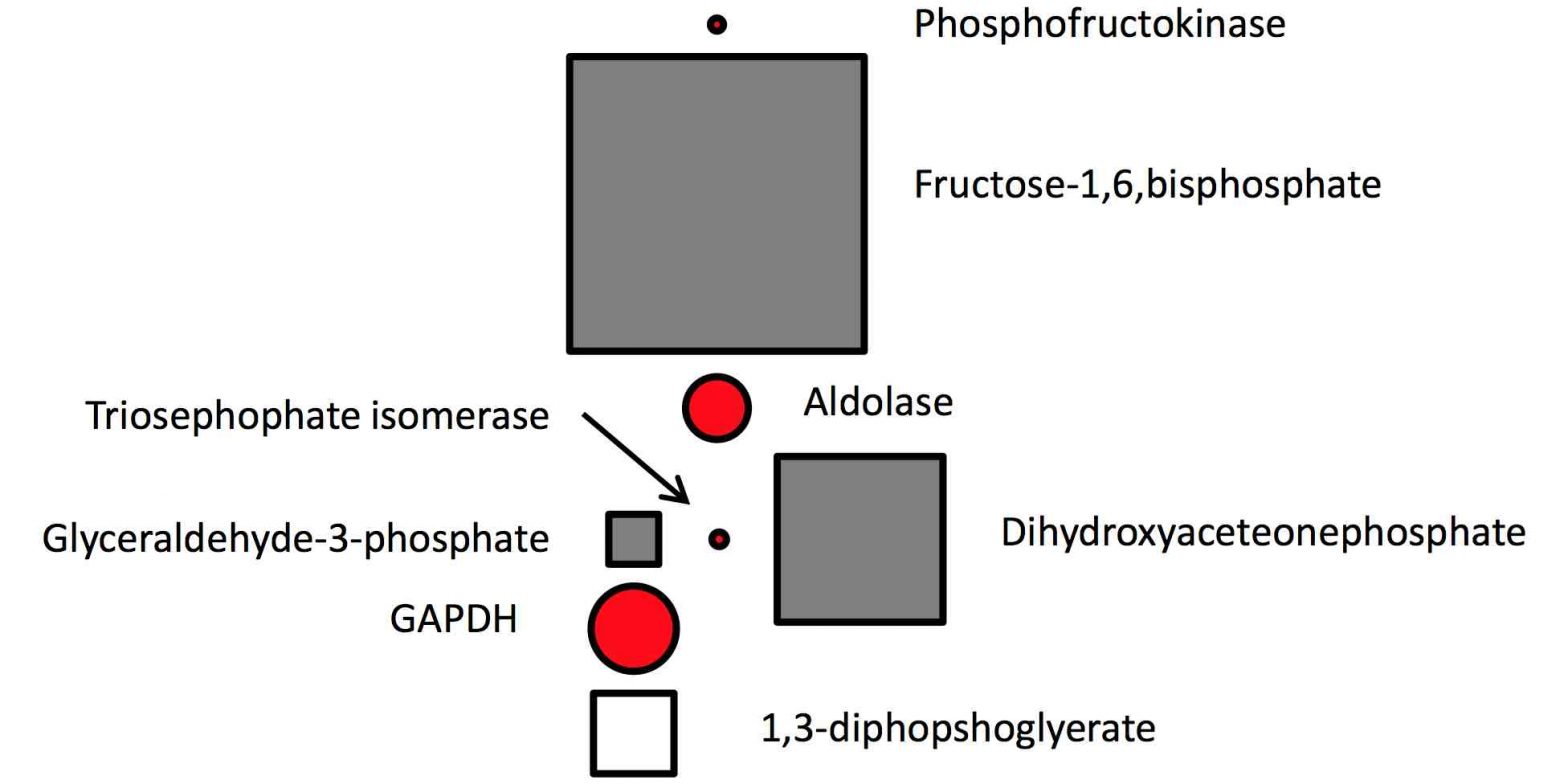

Von Glycogenspeichern und Fettstoffwechseltraining

Die Stundenleistung kann nur dann auch am Ende der Etappe in etwa erreicht werden, wenn die Glycogenvorräte des Sportlers noch gut gefüllt sind. Wenn wir nun schätzen, das ein Sportler einen Glycogenvorrat von insgesamt vielleicht 600-700 Gramm hat, erkennen wir, dass wir hier einen Leistungsbegrenzer haben. Immer dann, wenn der Sportler Vollgas fährt, verbraucht er ausschliesslich Kohlenhydrate. Selbst volle Speicher reichen also nur für 1,5 bis 1,8 Stunden Vollgas. Wir können uns aber vorstellen, dass der Sportler, der es schafft, mit seinen Glycogenvorräten vorsichtig umzugehen, auf die Dauer einer Tour de France Vorteile hat.

Das war nicht immer so. Aus den Aufzeichnungen von Bernhard Kohl zur Tour 2008 wissen wir, das er täglich mit Insulin gearbeitet hat. Insulindoping soll die Glycogenvorräte um bis zu 40 Prozent steigern. Mit Doping hat man also schlicht und ergreifend den „Tank“ vergrössert und konnte so länger schnell fahren. Was Kohl noch nicht wissen konnte, ist, dass man die Fettverbrennung auch im Bereich der Schwellenleistung (Stundenleistung) aktivieren kann (Studie von Jeukendrup). Die Trainingsroutine wird ergänzt durch eine wöchentliche Einheit in der der Fettstoffwechsel im Belastungsbereich zwischen 85 und 100 Prozent der Schwellenleistung (Stundenleistung) in Form von Intervallen trainiert wird. Zuvor werden die Speicher nahezu leer gefahren – mit enormen Lerneffekten des Körpers.

Der Sportler kann so den Anteil der Fettverbrennung an der Energieversorgung steigern und die Glycogenspeicher vergrössern. Das Konstrukt dieser Einheit ist so angelegt, dass der Sportler lernt mit erschöpften Speichern und seiner Wettkampfernährung noch Leistung zu bringen. Früher hat man lange 6-8 h Ausfahrten im ruhigen Tempo gemacht und so versucht, den Fettstoffwechsel zu optimieren. Wenn man bei solchen Ausfahrten dann in den Stunden 4-6 auch mal Berge mit höherer Leistung gefahren wäre, hätte man auch den oben geschilderten Effekt. Wenn wir den besseren Trainingseffekt aber in kürzerer Zeit gezielter hinbekommen, halten wir die Gesamtermüdung des Sportlers in Grenzen und gewinnen Platz im Trainingsplan für andere Einheiten und Trainingsinhalte. Hier sind weitere, sportmedizinische Hintergründe zum Fettstoffwechseltraining (pdf)

Individualisierte Rennernährung

Sie kennen als Zuschauer der Tour de France vielleicht noch die Silberlinge, die uns immer als Verpflegung der Profis dargestellt wurden? Heute weiß man, dass jeder Sportler eine individuelle Zusammensetzung seines Wettkampfgetränkes benötigt. Ideal ist ein Getränk, das zu einem Drittel aus Fructose und zwei Dritteln aus Einfach- oder Mehrfachzuckern besteht. Die Geschichte mit der Fructose (findet einen zusätzlichen Weg ins Blut) ist neu und dieses Wissen stand zumindest Armstrong und auch Ullrich noch nicht zur Verfügung. Man kann also heute bis zu ein Drittel mehr Nahrung aufnehmen und verarbeiten als früher. Man weiß heute auch, das in ein Wettkampfgetränk zusätzlich nur noch Salz und Koffein gehören. Alle andere Zugaben erhöhen ohne Nutzen die Anzahl der Teilchen und erschweren so die Verfügbarkeit und Menge der Kohlenhydrate.

Aus diesem Wissen folgt auch, dass man heute als Sportler mehrere Kohlenhydratlieferanten in Form von Maltodextrin, Wachsmaisstärke, Fructose (Verträglichkeit prüfen!) zu Hause hat und sukzessive austestet, mit welcher Mischung man am besten klarkommt. Zum Beispiel während der oben geschilderten Fettstoffwechseleinheit. Natürlich besteht aber auch ein Teil des Talents des Sportlers darin, möglichst viel Energie im Wettkampf aufzunehmen und umsetzen zu können.

Aber was ist mit dem Silberling? Während der Tour sollte ein Sportler jede Stunde nutzen, um sein persönliches Maximum an Nahrung pro Stunde zu sich zu nehmen. Während einer ruhigen Etappe im Feld können das 90 Gramm Kohlenhydrate pro Stunde sein. Da die Muskulatur arbeitet, wird der Zucker im Blut sofort verarbeitet und schont somit die Speicher. Am Berg in der Rennentscheidung wird man vermutlich je nach Sportler eher auf 50-60 Gramm pro Stunde gehen und eine Mischung nehmen, die sehr schnell ins Blut geht. Beschrieben wird das beispielsweise in dieser Studie zur Leistungssteigerung beim Zeitfahren durch veränderte Ernährungsstrategien.

Adam Hansen beim Aufstieg nach Alpe d’Huez. Gerüchten zur Folge entspricht das Getränk in seiner Hand nicht der offiziellen Zusammensetzung für Radprofis. Quelle: Twitter

Bleiben wir noch einen Moment bei den Glycogenvorräten, die es zu schonen gilt. Die Durchschnittleistungen bei einer Flachetappe können relativ niedrig liegen. Nehmen wir an, sie betrage 200 Watt. Dann verbraucht unser Sportler auf 200 km ca. 4000 kcal. Wenn wir diesem Sportler nun ein besonders eng anliegendes Trikot (Aerotrikot) anziehen und ihm einen Aerohelm aufsetzen und ihn auf einen Aerorahmen mit Aerolaufrädern setzen, können wir seine Durchschnittsleistung auf 170 bis 180 Watt reduzieren. Im Laufe einer normalen Etappe kann unser Sportler so seinen Energieverbrauch vielleicht um 500 kcal absenken. Das bedeutet von Tag zu Tag weniger Müdigkeit, weniger Belastung des Magen-/Darmtraktes und somit auch eine verbesserte Regeneration.

Bei einer rennentscheidenden Etappe hat unser professionell betreuter Sportler also einen Vorteil aus einer optimalen Fettverbrennung, seinem bestem Wettkampfgetränk und durch sein Material einen günstigen Luftwiderstandsbeiwert.

Auf der gestrigen Etappe mit dem zweimaligen Anstieg nach Alp d`Huez haben wir sehr deutlich gesehen, wie leere Speicher sich auf das Renngeschehen auswirken, aber auch wie unterschiedlich Fahrer darauf reagieren. Froome hat seine drohende Unterzuckerung rechtzeitig erkannt und konnte dann mit einem Gel die letzten fünf Kilometer noch so schnell fahren, das er auf die ihn verfolgende Gruppe von Contador nur ca. 10-15 Sekunden verlor. Da das Gel aber auch nicht sofort ins Blut geht, können wir davon ausgehen, das Froome das erste Anzeichen einer drohenden Unterzuckerung bemerkt hat. Der Leistungsmesser hilft hier.

Früher konnte man das hohe Tempo der Konkurrenz nicht mehr folgen und erzählte sich darüber Geschichten, heute weiß der leistungsgesteuerte Sportler, dass er Probleme hat, seine eigene Leistung zu erbringen und kann dann die richtigen Rückschlüsse ziehen. Gut, wenn man das im Training trainiert hat, zum Beispiel mit der oben dargestellten Trainingseinheit.

Neues Wissen, neue Trainingsmethoden?

Schauen wir uns noch mal ein bisschen näher das Training an. Zu Jan Ullrichs Zeiten wurden die Sportler auf ein Ergometer gesetzt und dann wurde ein Belastungsstufentest mit Spirometrie und Laktatmessung durchgeführt. Aus den Ergebnissen wurden dann Trainingsempfehlungen abgeleitet. Seit ein paar Jahren wissen wir, Laktat ist nicht nur ein Stoffwechselprodukt, das man als Parameter für die Ermüdung heranziehen kann, sondern spielt auch eine Rolle als Energieträger. Laktat kann also vom Sportler genutzt werden, um dem arbeitendem Muskel zusätzlich Energie zuzuführen.

Wenn wir früher bei Leistungssportlern die so genannte individuelle anaerobe Schwelle auf beispielsweise 400 Watt gelegt haben, dann konnte es durch aus sein, das dieser Sportler eine so genannte funktionelle (tatsächliche) Schwelle von 420 Watt hatte. Ich habe als Hobbysportler keinen Einblick in die Ergebnisse von Profisportlern, kenne aber persönlich nicht einen konventionellen Test im Hobbybereich der belastbare Trainingsempfehlungen gegeben hätte. Wenn Sie also Hobbysportler sind und Sie wollen ihre Leistungsfähigkeit untersuchen lassen, dann machen Sie es ruhig und sammeln sie die Daten, bis Sie sie selber interpretieren können.

Zurück zum Laktat und unserem neuen Wissen über seine Rolle als Energieträger. Mittlerweile gibt es erste Trainingsempfehlungen aus der Sportwissenschaft. Wir bauen Einheiten, in denen wir bewusst in einem Intervall Laktat erzeugen und dann die Leistung absenken, um das Laktat als Energieträger im Muskel zu verarbeiten. Wir fahren also 3-4 Minuten mit vielleicht 105-110 Prozent unserer Schwellenleistung und reduzieren dann die Leistung auf 85-95 Prozent für weitere 4 Minuten. Wenn die Tour näher kommt, würde man diese Übung dann entsprechend spezifizieren und mit Antritten am Berg kombinieren. Zum Beispiel 10 Sekunden hart antreten und dann für weitere 30 Sekunden das Tempo hochhalten und dann erst das Tempo auf 85-90 Prozent der Stundenleistung absenken.

Übrigens gab es schon immer Einheiten, wie z.B. das Schwellenkreuzen, mit denen man ähnliche Effekte erzielt hat. Neu ist heute, dass wir wissen, warum diese Einheit nützlich ist und zu welchem Zweck und wann sie eingesetzt werden kann. Verkürzend könnte man sagen, dass wir ähnlich der exogenen Versorgung mit Kohlenhydraten trainieren können, das Laktat als Energieträger zu nutzen; und zwar dergestalt, dass der Formaufbau begünstigt wird.Wir haben mit diesem Wissen also ein weiteres Puzzle, um unseren Sportler formaufbauend zu Tour zu bekommen.

Der Trainingsplan – gestern und heute

Wenn wir unseren Trainingsplan für unseren Tour de France Sieger 2014 zusammenbauen, hilft uns jedes neuere Wissen, die Einheiten entsprechend einzuplanen. Wir bekommen also mehr Qualität in unser Training. Bernhard Kohl hat in der „Zeit“ versucht, seinen Trainings- und Dopingplan zu rekonstruieren. Die Daten sind natürlich unvollständig und ich tue ihm vermutlich im folgenden Unrecht, möchte diesen Plan aber gerne als Beispiel nehmen.

Früher haben Leistungssportler im Oktober eine längere Ausszeit genommen. Radrennen sind sehr hart und sehr ermüdend. Nahezu jeder Profi und auch die meisten Hobbysportler haben am Ende des Jahres ein leichtes Übertrainingssyndrom. Eine Pause tut also gut und für die Gesundheit ist es förderlich, wenn man dem Körper eine z.B. 6 wöchige Regeneration gibt. Leider nimmt mir eine Pause von 4-6 Wochen fast die Chance, im nächsten Jahr stärker zu werden. Schon 2 Wochen Trainingspause reduzieren die Zahl der Mitochondrien dramatisch. Ich muss also beim Trainingsstart einen längeren Vorlauf einplanen, bevor ich wieder härter trainieren kann. Unserem Toursieger 2014 würde ich empfehlen, 2013 eine abgegrenzte Saison zu fahren und so die Ermüdung in Grenzen zu halten. Eine reine Saisonpause wäre dann hinfällig und unser Sportler könnte in einer Übergangsperiode von Mitte September bis Mitte Oktober aktiv mit Sport regenerieren.

Bernhard Kohl hat im Winter Langlauf gemacht, um wieder den Sport aufzunehmen. Für das Herz-Kreislauf-System ist es egal, welchen Ausdauersport wir wählen. Aber wenn wir nachdenken, werden wir unschwer erkennen, dass dieses Training auf dem Rad einen höheren Nutzen hat. Bernhard Kohl hat also Langlauf gemacht. Als Trainer hätte ich grosse Probleme, dieses Training in einer Trainingsplanung zu qualifizieren und auch die Trainingsbelastung zu messen. In der Trainingsplanung bauen wir auf Reize und auf Regeneration. Die Reize müssen sukzessive gesteigert werden. Jeden Tag vier Stunden Langlauf zu machen ist bestenfalls nett. Spätestens in der dritten Woche fange ich an meine Zeit zu verschwenden, wenn ich meinen Reiz nicht deutlich anpasse.

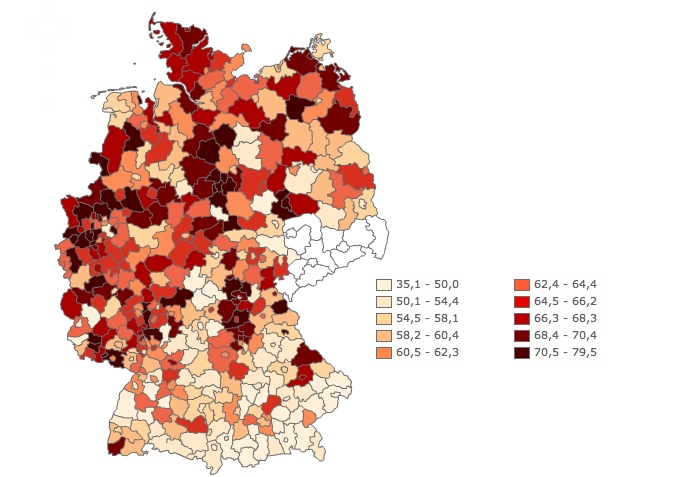

Leistungschart von Alejandro Valverde auf der neunten Etappe der diesjährigen Tour de France.

Verbesserte Leistungsmessung und Analysesoftware

Die Firma SRM hat für den Radsport einen Leistungsmesser bereits vor über 20 Jahren entwickelt. Mittlerweile gibt es diverse Softwareprogramme, die diese Leistungsdaten analysieren und den so genannten Trainingsload einer Einheit bewerten. Vereinfachend ausgedrückt werden Belastungen oberhalb der Schwelle deutlich stärker gewertet als Belastungen darunter. Mit dem Herzfrequenzmesser könnte Bernhard Kohl Belastungsspitzen durch kurze Hügel nicht wirklich erfassen, da die Herzfrequenz bis zu 3 Minuten Nachlauf hat. Wir fahren also einen Hügel hoch, sind sehr stark im anaeroben Bereich und unsere Herzfrequenz ist gerade mal von 120 auf 140 gestiegen. Unser Leistungsmesser zeigt aber, dass wir am Hügel 130 Prozent unserer Stundenleistung eingesetzt haben und diese Leistung korrespondiert eher mit einer Herzfrequenz von 180, die wir auch erreicht hätten, wenn der Hügel einen Kilometer länger gewesen wäre.

Für unsere Trainingsplanung sind solche Differenzierungen sehr wichtig. Durch die Messung der tatsächlichen Leistungen können wir die Reize viel genauer setzen und so auch die Regeneration viel besser steuern. In einer perfekten Trainingsumgebung kennt nicht nur der Trainer, sondern auch sein Schützling die Wirkweisen des richtigen Trainings und so können beide von Tag zu Tag die Feinsteuerung für das Training vornehmen. Natürlich hat es früher schon Ruhepulsmessungen morgens gegeben und es wurden Blutparameter gemessen. Nur die dann folgende Trainingsleistung kann man erst mit der Software für Leistungsmesser richtig setzen und auswerten. Wer es genau wissen will, kann sogar während der Ausfahrt den aktuellen Trainingsload vom „Tacho“ ablesen.

Wir können also einem Trainingstag eine Trainingsbelastung zuordnen und die Software kann uns dann anzeigen, wie sich der Trainingsload der letzten sieben Tage sich beispielsweise zum Trainingsload der letzten 42 Tage darstellt. Da man mittlerweile die Daten von vielen Leistungssportlern zum Vergleich hat, haben Trainer heute mehr Möglichkeiten, sich zu orientieren. Wir planen also unsere Trainingsbelastung für die Zeit von November bis Februar und steigern kontinuierlich den Trainingsload mit Einheiten, die für eine bestmögliche Basis für das weitere Training sorgen.

Man könnte neben vielen ruhigen Kilometern in dieser Zeit zum Beispiel auch harte, hochintensive Reize im so genannten Hittraining machen. Dieses hochintensive Training in Intervallform ist ein neuer und auch alter Hut. Die Sportwissenschaft arbeitet aktuell an Längsschnitten, die uns helfen werden, das Hittraining auch in die Mehrjahresplanung einzubauen. Aber schon heute sehen die Trainingspläne in nahezu allen gängigen Magazinen für Breitensportler deutlich roter (=intensiver) aus als noch vor einigen Jahren. Wer bislang noch wenig in diesem Bereich trainiert hat, wird von einem Hit-Trainingsblock vermutlich stark profitieren.

Softwareprogramme wie Golden Cheetah (opensource) verfügen über vielfältige Analysetools, zum Beispiel das Performancechart. Hier wird der aktuelle Trainingsload mit dem langfristigen Trainingsload verglichen. Wenn ich mein Pensum steigere, ist die aktuelle Belastung immer höher als die langfristige. Die Software erzeugt daraus die Trainingsstressbilanz, die dann in der Aufbauphase natürlich sehr stark negativ sein kann. Vor dem Wettkampf wird dann der aktuelle Trainingsload reduziert, um dann zum Wettkampf eine leicht positive Trainingsstressbilanz zu erzeugen. Der Sportler hat also ein Instrument, um die Trainingsbelastung zum Wettkampf genau auszusteuern; natürlich immer abgleichend mit eigenen Erfahrungswerten.

Von der Firma Trainingpeaks gibt es eine Kaufsoftware von Coggan und Allen, die sich seit über 20 Jahren mit dem Thema Training mit Powermeter beschäftigen. Hunter Allen hat sich in diesen Tagen auch zu den Berechnungen von Vayer geäussert. Allen hält aufgrund der vielen ihm vorliegenden Charts von Sportlern die 6,5 W/kg für sauber möglich. Andy Coggan hat sich gestern in Facebook dahingehend geäussert, dass er Leistungen von mehr als 9 W/kg im VO2 Max Bereich für physiologisch möglich hält und leitet daraus ca. 6,6 W/ kg als mögliche Stundenleistung ab. Wenn man sich die Topfahrer anschaut, liegen diese oftmals am Ende einer Tour nur 1-5 Minuten auseinander. Diese Unterschiede lassen sich mit einem Kg Gewichtsunterschied erklären.

Neue Trainingsmethoden sind besser als altes Doping

Wenn Sie mich fragen, ob die Leistungen von Wiggins und Froome sauber sind, würde ich das bejahen. Zwischen 1990 und 2010 gab es hinsichtlich des Wissens über „richtiges“ Radsporttraining eine Wissensexplosion. Natürlich hat die Trainingsmethodik unter Doping gelitten. Durch Conconi, Ferrari und co. wurde in der Trainingsmethodik der Focus sehr stark auf die Schwellenleistung und deren Beeinflussbarkeit durch Epo und Blutdoping gesetzt. Das Training in diesen Jahren stand sicherlich hinter den Möglichkeiten und Ergebnissen des Dopings zurück. Als Hobbysportler gebührt mein Respekt und meine Achtung den Sportwissenschaftlern, die unseren Sport mit ihrer Suche und Forschung nach weiteren Bausteinen, die unsere Erkenntnisse mehren und bereichern.

Der Radsport hat sich gewandelt. Teams wie Sky beschäftigen keine ehemaligen Doper. Die Sportler selber äussern sich heute eindeutig über Doper. Früher hätte man zum Doping der anderen geschwiegen und lediglich geleugnet selber zu dopen. Dieser Vorzeichenwechsel ist im Peleton erfolgt. Auch die aktuellen Leistungscharts z.B. von Valverde zeigen, dass die Sportler heute sauber sind. Der Radsport hat aus meiner Sicht an Faszination wieder gewonnen, weil die Leistungen nachvollziehbarer geworden sind.

Schauen Sie auf das Chart von Valverde und teilen Sie meine Leidenschaft für diesen Sport. Valverde hat am ersten Berg seine Helfer vorgeschickt und dann vor der Kuppe mit vielleicht 6,5-6,8 Watt/kg attackiert. Froome konnte ihm zwar folgen, war dann aber ohne Helfer. Die restlichen Berge der Etappe waren dann davon geprägt, dass Froome umzingelt von Gegner ohne eigene Helfer selber entscheiden musste, welche Gegner er kontrolliert. Die Leistungen von Valverde sind absolut plausibel. Ich kenne genug talentierte Hobbysportler, die natürlich mit höherem Gewicht, ähnliche Leistungen erbringen.

Freuen wir uns auf den heutigen Tag. Heute geht es zuerst über den Glandon, dann kommt der Col de Madeleine. Denken Sie heute mal an die Glycogenspeicher. Wenn auf den ersten beiden Bergen ein hohes Tempo gefahren wird, dann kann es durchaus sein, dass an den letzten Steigungen einige Topfavoriten sehr grosse Probleme bekommen. Sowohl Valverde als auch Contador sind beide überführte Doper. Beide sind aber auch herausragende Rennfahrer, die heute (sauber) den Radsport mit grosser Leidenschaft ausüben und aufgrund ihrer offensiven Fahrweise ihren Gegnern einen Wettkampf antragen, der an Faszination viel mehr zu bieten hat, als der Abgleich von Zahlen.

Der Autor dieses Gastartikels ist Diplomkaufmann und seit vielen Jahren begeisterter Radsportler, der auch Rennen fährt. Er beschäftigt sich beruflich unter anderem mit der Entwicklung von Carbonteilen für Rennrad und Mountainbike made in Germany (Projekt sizezero). Am 01. August ist die offizielle Vorstellung.

Der Autor schreibt hier unter dem Pseudonym Peter Sturm.

Weitere Artikel zur Tour de France hier im Blog: